@senspond

>

강화학습(Reinforcement Learning, RL) 핵심 개념과 용어정리

강화학습(Reinforcement Learning, RL) 핵심 개념과 용어위주로 정리해본 글입니다.

강화학습의 컨셉

강화학습은 지도학습(Supervised Learning)과 비지도학습(Unsupervised Learning)과는 다른 유형의 학습 방법이다. 지도학습은 주어진 입력에 대해 정답(라벨)을 사용해 학습하지만, 강화학습에서는 명확한 정답이 주어지지 않고, 에이전트가 행동에 대한 보상을 통해 경험을 쌓으며 학습한다. 강화학습의 핵심 목표는 누적 보상을 최대화하도록 에이전트가 최적의 정책(Optimal Policy)을 학습하는 것을 목표로 한다.

강화학습 용어정리

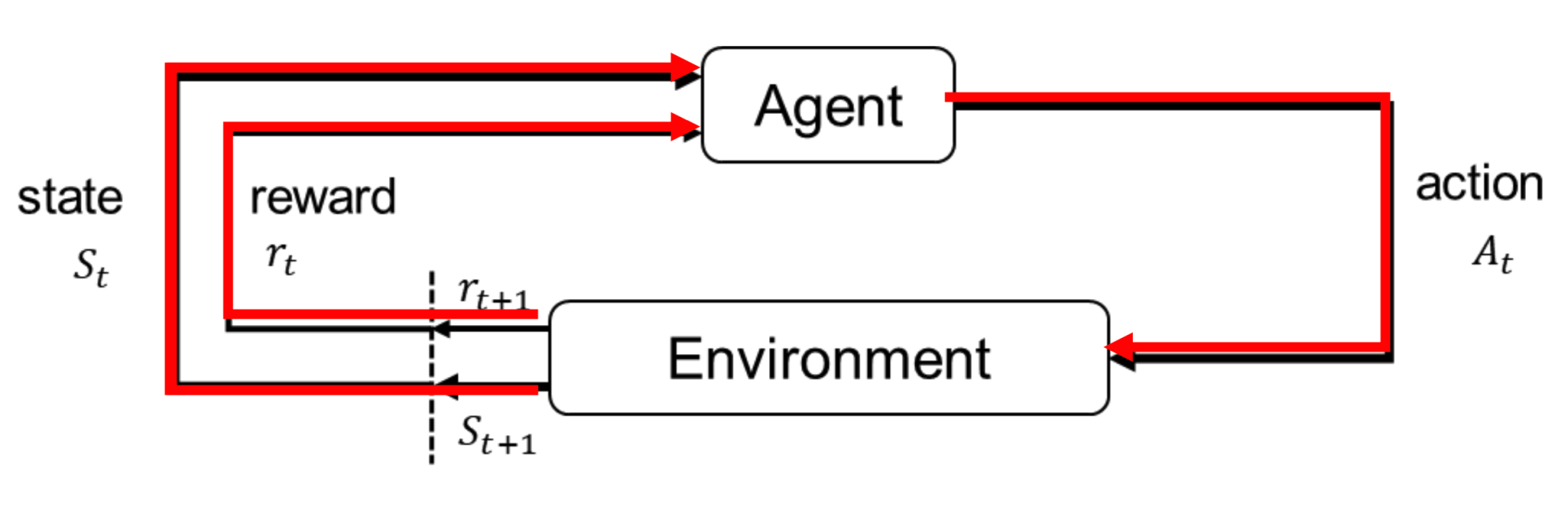

위 그림과 같이 강화학습은 환경과 상호작용하는 에이전트가 각 상태에서 어떤 행동을 했을때 누적 보상이 최대화 되도록 정책을 학습하는 것이 목표이다.

환경(environment)

강화학습(Reinforcement Learning, RL)에서 정말 중요한 핵심 키워드라고 할 수 있다. 환경은 풀고자 하는 문제가 어떻게 정의되어있는지, 즉 환경(environment)은 에이전트(agent)가 상호작용하는 외부 세계를 의미한다.

결정론적 환경(Deterministic world)

에이전트의 해동이 항상 같은 결과를 초래. 즉 어떤 상태에서 특정 행동을 취하면 항상 동일한 상태로 전이되고, 동일한 보상을 받는 환경

이 환경에서는 불확실성이 없고, 모든것이 예측 가능한 환경이다. 실제 세상(Real World)에서는 대부분의 환경이 불확실성을 포함하기 때문에, 결정론적 환경은 강화학습 문제를 완벽하게 설명하지 못하는 경우가 많다.

확률적 환경(Stochastic world)

미로찾기 경로탐색과 같이 동일한 행동에 대해 동일한 결과로 표현할 수 있다면 결정론적 환경이라고 할 수 있고, 자율 주행차 처럼 날씨, 교통 상황, 도로 상태에 따라 다르게 반응하는 경우라면 확률적 환경에 해당한다고 할 수 있다.

결정론적 환경에서는 행동의 결과가 항상 일정하기 때문에, 에이전트는 한 번의 학습만으로 최적 정책을 빠르게 찾을 수 있다.

확률적 환경은 현실 세계의 복잡한 상황을 더 잘 반영하며, 에이전트가 여러 번의 시도를 통해 불확실성을 학습하게 만든다.

에이전트(Agent)

환경에 대해 여러 가지 행동을 반복하면서 최적의 행동을 학습, 환경과 상호작용 하는 주체이다.

상태(State)

에이전트가 감지하고 있는 환경의 정보를 의미한다. 예를 들어 로봇의 미로찾기 문제에서는 로봇의 현재위치, 로봇 주의 정보가 될 수 있고 인공지능 바둑 에이전트에서는 바둑판 위의 현재 흑백 돌의 배치 같은 경우가 될 수 있다.

행동(Action)

에이전트가 취할 수 있는 선택을 의미한다.

예를 들어 미로찾기 문제에서는 해당 위치에서 왼쪽으로 이동할지, 오른쪽으로 이동할지 등이 에이전트가 취할수 있는 행동으로 정의될 수 있고,,

자동 주식 트레이닝 에이전트에서는 특정시점에서 사기, 팔기, 홀딩 같은 행동이 정의 될 수 있다.

에피소드

초기상태부터 마지막 상태까지 에이전트가 거친 (상태, 행동, 보상)의 과정을 의미.

예를 들어, 체스나 바둑과 같은 보드 게임에서는 게임의 시작부터 끝날 때 까지가 하나의 에피소드라고 할 수 있고, 자율주행 도로 주행 시뮬레이션에서는 시작 위치에서 주행을 시작해 목표 지점에 도착하거나 사고가 나서 주행이 끝날 때까지의 과정을 에피소드라고 할 수 있다.

강화학습은 에피소드 기반의 학습과 비 에피소드 기반의 학습으로 나눌 수 있는데, Q-Learning과 Monte Carlo 와 같이 에피소드 기반 알고리즘이 많이 사용된다.

보상(Reward)

에이전트가 취한 행동에 대해 환경으로부터 좋고 나쁨의 평가를 수치적으로 받은것을 의미한다.

에이전트가 특정 행동을 취했을 때 환경으로부터 받는 즉각적인 피드백으로, 보상은 에이전트가 행동을 선택할 수 있는 가치신호가 된다.

보상의 유형 : 긍정적보상, 부정적보상(패널티), 무보상

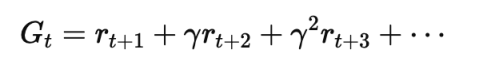

수익(Return)

에이전트가 현재시점부터 미래에 걸쳐 얻은 보상의 총합이다. 보상은 즉각적이지만, 에이전트는 장기적으로 얼마나 많은 보상을 얻을 수 있늘지 고려하여 행동을 취해야 한다.

그런데 모든 보상을 있는 그대로 더해버리면, 무수히 많은 학습을 해가면서 수익이 무한대로 발산해버릴 수가 있다.

그렇게 되서는 제대로 된 수익평가를 하기 어렵다. 그래서 할인율이라는 개념이 필요하다.

할인율(Discount Factor: r)

미래에 받을 보상의 현재가치를 계산할 때, 미래 보상이 현재 시점에서 얼마나 중요한지를 결정하며, 할인율을 통해 장기적인 보상의 가치를 조정하게 된다. 미래의 보상을 할인하여 현재시점에서 평가하는 방식으로, 미래의 불확실성이나 기회비용을 반영하는 요소이다. 이 할인율은 경제학에서도 자주 사용되는 개념으로, 미래의 현금 흐름이나 수익을 현재가치로 환산하는데도 비슷한 개념으로 사용이 된다.

할인율이 큰 경우 : 에이전트는 장기적인 보상을 중요하게 생각한다. 미래의 큰 보상을 위해 당장 작은 보상을 포기할 수 있음

할인율이 작은 경우 : 에이전트는 즉각적인 보상을 미래의 보상보다 중요하게 생각.

정책(policy)

에이전트가 어떤 상태에서 어떤 행동을 선택할지를 결정하는 규칙(함수)이다. 정책은 상태 s에서 에이전트가 취할 행동 a에 대한 확률 분포를 나타낸다. 즉, 정책은 주어진 상태에서 에이전트가 어떤 행동을 선택 해야하는지에 대한 전략이라고 할 수 있다.

확정적 정책(Deterministic Policy) : 상태 s에서 항상 같은 행동 a를 선택하는 정책

확률적 정책(Stochastic Policy) : 상태 s에서 행동 a를 확률적으로 선택하는 정책

정책 반복과 탐색

정책 반복 : 에이전트는 현재 정책을 평가한 후, 그 정책을 개선하여 더 나은 정책을 학습한다.

정책 탐색 : 에이전트는 여러 정책을 탐색하여, 각 정책의 기대 보상을 기반으로 최적 정책을 찾는다.

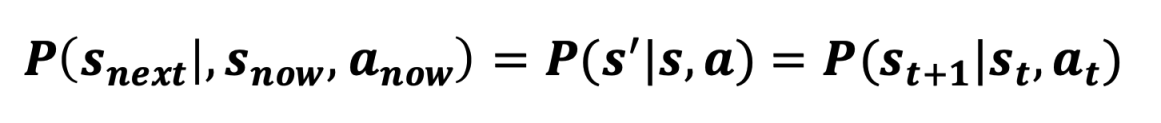

상태전이확률(P)

상태 전이 확률(State Transition Probability)은 에이전트가 현재 상태에서 특정 행동을 했을 때, 다음 상태로 전이될 확률을 의미한다. 이 확률은 환경의 불확실성을 모델링하는 데 사용된다.

에이전트는 이 정보를 사용해 자신의 행동이 미래에 미칠 영향을 예측할 수 있다.

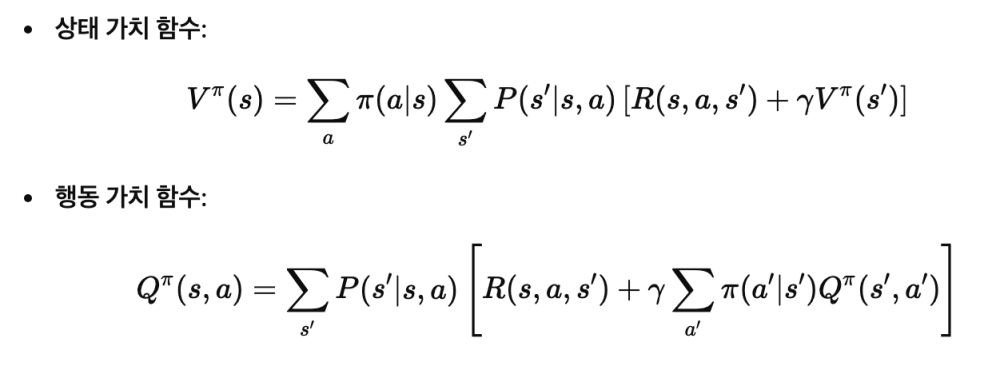

가치함수(Value Function)

특정 상태에서 시작하여 에이전트가 얻게 될 누적 보상의 기대값을 나타낸다.

가치 함수는 상태 또는 상태-행동 쌍의 미래 보상의 기대값

상태 가치 함수 V(s) : 상태 s에서 시작해 정책을 따랐을 때 얻을 수 있는 기대 보상

행동 가치 함수 Q(s,a) : 상태 s에서 행동 a를 했을 때 이후에 얻을 수 있는 기대 보상

여기서 P는 상태전이확률을 의미. 가치함수는 벨만 기대 방정식을 통해 상태-행동의 가치를 재귀적으로 계산 할 수 있다.

레퍼런스

기초부터 시작하는 강화학습 신경망 알고리즘 [국내도서]

안녕하세요. Red, Green, Blue 가 만나 새로운 세상을 만들어 나가겠다는 이상을 가진 개발자의 개인공간입니다.

댓글 ( 0 )

카테고리내 관련 게시글

현재글에서 작성자가 발행한 같은 카테고리내 이전, 다음 글들을 보여줍니다

@senspond

>